おひさしぶりです。広島のローリングストーンもりひめです。

ここ1カ月ぐらいなにやっていたのかというと、はい・・・仕事です。

さて、もうすぐ4月!!

Xperiaも発売されますね!!

そんなXperiaと一緒に使ってほしいアイテム、「JabraCLIPPER」のご紹介をするために

なんと!!

イベントに出ることになりました!!

「JabraCLIPPER PRESENTS

SPRING STEP ~春色美人のワイヤレスライフ~」

4月1日

渋谷iPRESS CAFE

19:00~21:00

出演者:日本Androidの会 女子部部員 もりひめ

ジョグノート代表 素敵美人様(名は伏せる)

某社 お姉さま(名は伏せる)

大抽選会もあります!!

みなさまお近くにお越しの際には

また、遠くからでも足をはこんでください!!

・・・と言いたいところですが、

人数がかーなり限定されているらしいので

申し訳ないのですが、参加されたい方はDMください。(3/31必着)

力はないですが、なんとかできるかもしれません。

えーっと、なんともならなくても

Ustreamで配信されるらしいので

ハッシュタグ #jabrajp でつぶやいてください!!

私も裏方をつぶやけたらつぶやきますので。

できたらDMくださって足をはこんでいただけたら、私がもみじまんじゅうをくばるかもしれません。

もしくはヒールの高い靴で頭から転倒するかーですね。

死ぬ気で(AndroidとJabraの)PRをしますのでよろしくお願いします!

・・・裏方レポートはまた。

みなさま、ぜひご覧ください!!

4/1は渋谷iPRESSCAFEもしくはお茶の間のパソコンの前で!!

リアルでも映像でもお待ちしております。

とこんな感じで

ばたばたとした告知ですみません・・・。(しかも直前)

(もりひめ/広島のローリングストーン)

2010年3月22日月曜日

日本Androidの会 3月の定例イベント潜入レポート!その3+α

2010/2/15から18日までスペインのバルセロナで開催された携帯電話の世界的イベント、MWC2010の模様を日本Androidの会の事務局のたじまさんからご報告がありました。飄々とした語り口調で現地の雰囲気を伝えていただきました!

会場の広さは幕張メッセと東京ドームを足したぐらいの広さでそこに世界中から1300社もの会社が出店とのこと。会場付近でも、闘牛場の壁全面を使ったSamsungの広告や地下鉄への階段の壁面をつかったWindows Phoneの広告など、いたるところで携帯電話がフューチャーされていてとても熱い雰囲気だった模様です!全体の雑感としては、

基調講演は今一番注目されるGoogleCEOのエリックシュミット氏。質疑応答のコーナーではみんな熱くなりすぎてガチンコのバトルが繰り広げられていたそうです。日本からはKDDIの社長が今回GSMAに参加した関係もあって登壇されていた模様。展示品の模様は以下の端末について写真付きで紹介していただきました。

最後に、よもやま話として、会場のネット環境と食べ物の物価が非常に高い!と憤慨されておられました。なので現地でSIMを慣れない英語で2種類調達し、アクティベーションに丸一日かかったという苦労話も披露。またカンファレンス費用は500~3000ユーロと高額なので社費で行く場合は予算取りを忘れないようにねとアドバイスでされてました(海外のイベントは高額です)。

現地の熱さが伝わってくるとても面白いお話でしたが、会場使用時間の都合でとばし気味だったのが残念。この後は懇親会になりました。

定例イベントのあとは毎度おなじみの懇親会です!会場は戦後の闇市を感じさせる雰囲気の池袋の某居酒屋さん。そしてなんと100名を超える方が懇親会に参加されました。規模は過去最大です!そしてざっくばらんな雰囲気の中、あちこちで名刺交換する光景が見られました。

今回は特別に、先程のたじまさんよりMWC2010グッズを提供していただけましたので、「第一回チキチキMWC2010グッズ強奪ジャンケンゲーム!」がとりおこなわれました!

見事100名余りの参加者の中、じゃんけんで勝ち抜かれたのは、こちらの山﨑様でした。MWC2010のノベルティであるリュックが手渡されて、そして…

中には、Nexus Oneが!!! すげー!

(写真がブレ具合で山﨑様の歓喜がいかほどのものか伝わるかと思います…)

山﨑様はバッリバリの開発者とのこと。是非とも今回当たったNexus OneでAndroidアプリを作成していただけることに期待します!そして、想定外のサプライズのおかげで懇親会は終始大盛り上がりでした。参加された皆様、おつかれさまでした!

会場の広さは幕張メッセと東京ドームを足したぐらいの広さでそこに世界中から1300社もの会社が出店とのこと。会場付近でも、闘牛場の壁全面を使ったSamsungの広告や地下鉄への階段の壁面をつかったWindows Phoneの広告など、いたるところで携帯電話がフューチャーされていてとても熱い雰囲気だった模様です!全体の雑感としては、

- スマートフォンばかり(エントリーモデルからスマートフォン!)

- Android対応はもはや当たり前。あとはiPhone、BlackBerryが主流。

- Samsungもアプリケーションマーケットを構築して、メジャーなメーカーのアプリケーションマーケットは一通り揃った感じ

- 日本の出展社元気なさすぎる!技術的内容は海外企業とそんなに遜色ないのに…

基調講演は今一番注目されるGoogleCEOのエリックシュミット氏。質疑応答のコーナーではみんな熱くなりすぎてガチンコのバトルが繰り広げられていたそうです。日本からはKDDIの社長が今回GSMAに参加した関係もあって登壇されていた模様。展示品の模様は以下の端末について写真付きで紹介していただきました。

- Sony Ericsson … Xperia mini pro、Xperia X10

- HTC … REGEND、DESIRE

- Samsung … Galaxy、WAVE(これは非android)

- General Mobile … COSMOS2

- Motorola … BACKFLIP

- Huawei … Smakit S7

- HP … Android搭載のNetbook

- Garman Asusのナビゲーションシステム

- Power Mat … 去年あたりからヨーロッパでは発売されてた非接触型充電器で結構売れているそう。メーカーと提携して、携帯の添付品として販売されそうな勢い。

- Bluestreak … モバイルソリューションの会社で、Mobile TVなどのアプリケーションサービス。

- Orange … ヨーロッパ全土で活躍するフランスの会社。某XperiaのTimescapeみたいなアプリを展示。だけどTimescapeとは異なりサーバで情報蓄積しているそうです。Android Marketからダウンロード可能だそうです。

- Docomo … ガラケーの展示多し

- TOSHIBA … Windows Mobile搭載機の展示

最後に、よもやま話として、会場のネット環境と食べ物の物価が非常に高い!と憤慨されておられました。なので現地でSIMを慣れない英語で2種類調達し、アクティベーションに丸一日かかったという苦労話も披露。またカンファレンス費用は500~3000ユーロと高額なので社費で行く場合は予算取りを忘れないようにねとアドバイスでされてました(海外のイベントは高額です)。

現地の熱さが伝わってくるとても面白いお話でしたが、会場使用時間の都合でとばし気味だったのが残念。この後は懇親会になりました。

定例イベントのあとの懇親会レポート

定例イベントのあとは毎度おなじみの懇親会です!会場は戦後の闇市を感じさせる雰囲気の池袋の某居酒屋さん。そしてなんと100名を超える方が懇親会に参加されました。規模は過去最大です!そしてざっくばらんな雰囲気の中、あちこちで名刺交換する光景が見られました。

今回は特別に、先程のたじまさんよりMWC2010グッズを提供していただけましたので、「第一回チキチキMWC2010グッズ強奪ジャンケンゲーム!」がとりおこなわれました!

見事100名余りの参加者の中、じゃんけんで勝ち抜かれたのは、こちらの山﨑様でした。MWC2010のノベルティであるリュックが手渡されて、そして…

中には、Nexus Oneが!!! すげー!

(写真がブレ具合で山﨑様の歓喜がいかほどのものか伝わるかと思います…)

山﨑様はバッリバリの開発者とのこと。是非とも今回当たったNexus OneでAndroidアプリを作成していただけることに期待します!そして、想定外のサプライズのおかげで懇親会は終始大盛り上がりでした。参加された皆様、おつかれさまでした!

日本Androidの会 3月の定例イベント潜入レポート!その2

前回に引き続き、女子部のゴン太くん、ニシヲカがレポートします!

次のセッションでは、NTTサイバースペース研究所の高橋 敏さん。先ほどの中村さんの基礎技術を応用していろいろなアプリ・サービスを開発されているそうです。このセッションでは音声認識エンジンのサービスへの応用例と、音声認識ならではのサービスづくりのコツについてご披露いただきました。なんて太っ腹!高橋さん曰く、少しでも良いサービス、アプリ開発のヒントになればとのこと。聞いたかAndroid開発者の諸君!立ち上がれ!

まずはNTTの音声認識エンジンVoiceRexのご紹介です。分散型音声認識を行っています。これは端的に言うと、サーバクライアントシステムです。音声認識の処理をクライアント側とサーバ側に分けて実施します。android携帯のような、クライアント側で特徴量算出・符号化・ 圧縮までを行い、そのデータをサーバ側へ送信して音声認識処理を行います。もちろん、複数人の音声認識に対応しています。そして、VoiceRexを使ったサービスは、次の3パターンに大別されるそう。

それぞれどういったサービスで使われているか、実際デモしていただき、具体的にわかりやすくご紹介いただきました。

キーボードやマウスの代わりに人の声で機械を操作しよう!といったものです。今回は音声カーナビとTV番組表検索エージェントのデモを披露していただけました。人が何回も言い間違えるようなことがあっても、間違いに的確に対応して本来の正しい答えを返しており、まるで機械の中に人がいるようです!すばらしい!認識自体は文脈で判断するため、方言にイントネーションの違いがあっても大丈夫。例えば、「箸」と「橋」の違いなどは全然問題ないそうです。

ただたまにとんでもない間違いをすることがあるらしく、音声カーナビなどありえないルートを示すことも。そのような時は、開発者のサガというか、正しいルートがでるまで意地でも何回も機械と会話をしてしまうそうです。なんだかほほえましいながら地道な努力!

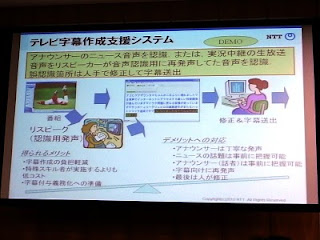

会話の内容を、話すそばから自動的に記録としてテキストで残すようなサービスです。たしかに、話した内容をあとから思い出して正確にテキストにおこす作業は大変ですよね。今回はTV字幕作成支援システムと議会録作成システムをご紹介いただきました。

TV字幕作成システムでは、ニュースでアナウンサーが話すような情報をテキストにおこします。しかし話し言葉は書き言葉に比べて、無駄な情報がどうしても多くなります。ニュース番組だとある程度情報が整理されたうえで話をきくことができますが、これがバラエティだととても大変とのこと。実験的に、おしゃべりな司会者で有名なみのもんたさんの番組で試したところ、とてつもなく大変なことになったそうです。でもご安心。このような場合、リスピークといった字幕専用のアナウンスをすることで対処しているそうです。また細かい間違いはどうしても残ってしまうのでこれは手作業で直すそうです。でも一から入力するよりも作業の負担が減るので有意義なシステムですね!現在実用化に向けて開発が進められているそうです。

もうひとつ、ご紹介いただいた音声議会録作成システムは、国会などの議会での記録とるようなシステムです。これも、TV字幕作成と同様の課題をかかえており、議会などには適していますが、会社の会議などの場合には適さないようです。何がどう異なるのでしょうか?その違いをわかりやすく提示していただきました。

やはり、なんとなく話すような話し言葉は情報が整理されていないので、要点をいかにまとめるか?というところがこのサービスの大きな課題になるようです。

大量の音声情報から必要なものだけを抽出するようなサービスです。これは最近はやりのサービスだそうで、主にコールセンターで利用されています。コールセンターにかけた電話で苦情や要望などを話すと、自動的に内容を解釈し、マーケティングをしたり、苦情の傾向・分析を行うそうです。またコールセンターのオペレーターがちゃんと丁寧に応対しているかってことも分析するそうです。これはオペレータの方はサボれませんね。しかし、消費者の声がダイレクトに素早く企業に届くことになりますので、我々にとってはありがたい技術です!

音声認識がサービスとして使われる場合、いっぱい良いところがあります。まずは、人に優しいインタフェースであること。会話ができる人ならば誰でも簡単に使えちゃうところです。例えばキーボードの操作に慣れていない高齢者の方、または手に怪我をされていたり大きな荷物を持っていたりなどで操作ができない人でも簡単に話すだけで操作できちゃいます。また、最小限マイクとスピーカーがあれば実現できるので、場所もとらないでサービスを受けることができます。

でもでも、まだ発展途上の技術なので、音声認識ならではの欠点もまだあります。

そして最後ですが、最大の課題があります。

人が機械に向かってしゃべるのは、心理的に抵抗がありませんか?最近は携帯電話に向かって話すことは当たり前になりましたが、これは携帯電話を持っているから平気なのです。例えば電話を持たずにヘッドセットにしゃべるのはどうでしょう?結構キツイですよね。またヘッドセットでしゃべっている人と出会うだけでもギョッとする。そういう人はまだまだ多いです。しかし、こういった抵抗感を意識せずに使ってもらえるようなサービスを提供すること。これが音声認識の一番の課題であり、そして音声認識がどんどん進化するための絶対条件になります。そして我々のようなAndroidアプリ開発者にも、アプリやサービスの開発によって、そのような文化へと進化させることに期待しています、との締めの言葉でこのセッションは終了いたしました。

壮大すぎる!結構なムチャぶりですね!でももし既存の文化がくつがえるようなサービスが実現できたなら…。それは確実に世の中が変わる一つのきっかけになるでしょう。あなたならどうしますか?

さてさて、次のセッションでは、スペインのバルセロナで開催された携帯電話の世界的イベント、MWC2010の模様をレポートします!

次のセッションでは、NTTサイバースペース研究所の高橋 敏さん。先ほどの中村さんの基礎技術を応用していろいろなアプリ・サービスを開発されているそうです。このセッションでは音声認識エンジンのサービスへの応用例と、音声認識ならではのサービスづくりのコツについてご披露いただきました。なんて太っ腹!高橋さん曰く、少しでも良いサービス、アプリ開発のヒントになればとのこと。聞いたかAndroid開発者の諸君!立ち上がれ!

まずはNTTの音声認識エンジンVoiceRexのご紹介です。分散型音声認識を行っています。これは端的に言うと、サーバクライアントシステムです。音声認識の処理をクライアント側とサーバ側に分けて実施します。android携帯のような、クライアント側で特徴量算出・符号化・ 圧縮までを行い、そのデータをサーバ側へ送信して音声認識処理を行います。もちろん、複数人の音声認識に対応しています。そして、VoiceRexを使ったサービスは、次の3パターンに大別されるそう。

- 音声インタフェースとしての利用(音声コマンド)

- ディクテーションとしての利用(口述筆記)

- 音声マイニングとしての利用

それぞれどういったサービスで使われているか、実際デモしていただき、具体的にわかりやすくご紹介いただきました。

音声インタフェースとしての利用(音声コマンド)

キーボードやマウスの代わりに人の声で機械を操作しよう!といったものです。今回は音声カーナビとTV番組表検索エージェントのデモを披露していただけました。人が何回も言い間違えるようなことがあっても、間違いに的確に対応して本来の正しい答えを返しており、まるで機械の中に人がいるようです!すばらしい!認識自体は文脈で判断するため、方言にイントネーションの違いがあっても大丈夫。例えば、「箸」と「橋」の違いなどは全然問題ないそうです。

ただたまにとんでもない間違いをすることがあるらしく、音声カーナビなどありえないルートを示すことも。そのような時は、開発者のサガというか、正しいルートがでるまで意地でも何回も機械と会話をしてしまうそうです。なんだかほほえましいながら地道な努力!

ディクテーションとしての利用(口述筆記)

会話の内容を、話すそばから自動的に記録としてテキストで残すようなサービスです。たしかに、話した内容をあとから思い出して正確にテキストにおこす作業は大変ですよね。今回はTV字幕作成支援システムと議会録作成システムをご紹介いただきました。

TV字幕作成システムでは、ニュースでアナウンサーが話すような情報をテキストにおこします。しかし話し言葉は書き言葉に比べて、無駄な情報がどうしても多くなります。ニュース番組だとある程度情報が整理されたうえで話をきくことができますが、これがバラエティだととても大変とのこと。実験的に、おしゃべりな司会者で有名なみのもんたさんの番組で試したところ、とてつもなく大変なことになったそうです。でもご安心。このような場合、リスピークといった字幕専用のアナウンスをすることで対処しているそうです。また細かい間違いはどうしても残ってしまうのでこれは手作業で直すそうです。でも一から入力するよりも作業の負担が減るので有意義なシステムですね!現在実用化に向けて開発が進められているそうです。

もうひとつ、ご紹介いただいた音声議会録作成システムは、国会などの議会での記録とるようなシステムです。これも、TV字幕作成と同様の課題をかかえており、議会などには適していますが、会社の会議などの場合には適さないようです。何がどう異なるのでしょうか?その違いをわかりやすく提示していただきました。

| 議会(国会など) | 会議(会社でのミーティングなど) |

|

|

やはり、なんとなく話すような話し言葉は情報が整理されていないので、要点をいかにまとめるか?というところがこのサービスの大きな課題になるようです。

音声マイニングとしての利用

大量の音声情報から必要なものだけを抽出するようなサービスです。これは最近はやりのサービスだそうで、主にコールセンターで利用されています。コールセンターにかけた電話で苦情や要望などを話すと、自動的に内容を解釈し、マーケティングをしたり、苦情の傾向・分析を行うそうです。またコールセンターのオペレーターがちゃんと丁寧に応対しているかってことも分析するそうです。これはオペレータの方はサボれませんね。しかし、消費者の声がダイレクトに素早く企業に届くことになりますので、我々にとってはありがたい技術です!

音声認識の技術をサービス・アプリにいかすには?

音声認識がサービスとして使われる場合、いっぱい良いところがあります。まずは、人に優しいインタフェースであること。会話ができる人ならば誰でも簡単に使えちゃうところです。例えばキーボードの操作に慣れていない高齢者の方、または手に怪我をされていたり大きな荷物を持っていたりなどで操作ができない人でも簡単に話すだけで操作できちゃいます。また、最小限マイクとスピーカーがあれば実現できるので、場所もとらないでサービスを受けることができます。

でもでも、まだ発展途上の技術なので、音声認識ならではの欠点もまだあります。

- 機械も聞き間違えをする

- しかも人間の場合だとありえないようなとんでもない間違い

- 同じ間違いを何度も繰り返す

- 入力音声には制約がある

- 発話する環境次第で、処理の精度が変わる

- 要点をまとめてしゃべるようにしないと正確に処理できない

- どういう言葉をどういうふうにしゃべったらいいのか利用者にわかりづらい

- 音声認識辞書にない新しい単語は認識できない

- そもそも音声認識が適用しやすいサービスで使用すること

- 間違って入力しても簡単に訂正できるような仕組みを作ること

- なにをしゃべったらよいかをわかりやすく利用者に示すこと

- サービスの用途に合わせて辞書を充実させること

そして最後ですが、最大の課題があります。

端末に向かってしゃべる文化をいかに当たり前にするか?

人が機械に向かってしゃべるのは、心理的に抵抗がありませんか?最近は携帯電話に向かって話すことは当たり前になりましたが、これは携帯電話を持っているから平気なのです。例えば電話を持たずにヘッドセットにしゃべるのはどうでしょう?結構キツイですよね。またヘッドセットでしゃべっている人と出会うだけでもギョッとする。そういう人はまだまだ多いです。しかし、こういった抵抗感を意識せずに使ってもらえるようなサービスを提供すること。これが音声認識の一番の課題であり、そして音声認識がどんどん進化するための絶対条件になります。そして我々のようなAndroidアプリ開発者にも、アプリやサービスの開発によって、そのような文化へと進化させることに期待しています、との締めの言葉でこのセッションは終了いたしました。

壮大すぎる!結構なムチャぶりですね!でももし既存の文化がくつがえるようなサービスが実現できたなら…。それは確実に世の中が変わる一つのきっかけになるでしょう。あなたならどうしますか?

さてさて、次のセッションでは、スペインのバルセロナで開催された携帯電話の世界的イベント、MWC2010の模様をレポートします!

2010年3月15日月曜日

日本Androidの会 3月の定例イベント潜入レポート!その1

2010年3月8日(月)に開催された日本Androidの会3月の定例イベントにいってまいりました!その模様を女子部のゴン太くんこと、ニシヲカがレポートします。

今回のテーマは「音声認識」になります。音声認識とは、機械が人の声をきいてそれを文章にする技術です。人が何気なくやってることを機械にやってもらおう! というもので、最近はiPhoneやAndroidのアプリでもぽつぽつ見かけるようになりました。でもまだ、日常では使えないよね〜と思っている方も多いのではないでしょうか?しかしそれはとっても難しい技術なんです。そんな未来の技術を頑張って取り組んでいる方々の熱いお話を聞くことができました。

トップバッターは、NTTコミュニケーション科学基礎研究所の中村 篤さん。NTTでの音声認識研究の最前線をお話ししていただけました。専門的な言葉が飛び交いまるで大学の講義のような雰囲気です。

まずは、音声認識の簡単なご説明。一口に音声認識といってもいろいろな処理が必要です。なんと、音が入力されてから言葉になるまで、こんなにも処理をしないといけないのです。

- 音を読み取ってきれいな波形信号に加工する。(音響処理)

- 音声以外のノイズを除去して単なる音のかたまりから音声の部分だけをとりだす。そして音の特徴だけを取り出す。(音響音声処理)

- 認識エンジンにかける!(音声認識)

- 1つ1つ音声を単語にする(音声言語処理)

- 単語をまとめてちゃんとした文章を作る(自然言語解析)

まったくもってよくわかりません…。つくづく人の脳みそって賢いですね!実際、機械に音声認識させることはとっても難しいのだそうです。

人が人の言葉を聞きとるのはこんなに簡単なのに、機械にやらせるとなんて難しいのか…。では人間の場合はどういう仕組みで言葉を聞いているのでしょうか?

人が人の言葉を聞きとるのはこんなに簡単なのに、機械にやらせるとなんて難しいのか…。では人間の場合はどういう仕組みで言葉を聞いているのでしょうか?

- 音を感じる…耳から聴覚野という大脳の音を刺激として感じる部分に伝達される

- 言葉を聞く…耳から聴覚野を経由して、大脳の側頭連合野という言葉を理解する特別な部分へ伝達される

言葉を聞く場合は、音と違って脳への伝達も特別です。人はまず言葉と音とを区別して聞き、声から発せられた言葉は意味のあるものとして特別な方法で処理しています。音声認識でも同様で、声と音を区別する仕組み/声を言葉として理解する仕組みが必要となります。そこでNTTさんでは2つの技術で音声認識を実現 しています。

声と音を区別する仕組み…音声区間検出&雑音抑制技術DIVINE

言葉を聞き取るためには、まず、声の部分だけ取り出したい。そのために音の部分は除去する技術がDIVINEです。NTTで研究開発されたこの技術のすごいところは、雑音などの下でも、正確に目的の声だけをとりだせるところ!例えば、会話しているときに車が通ったら場合でも、会話内容だけを抽出します。人でも騒音の中で会話は聞きとりにくくてむずかしいですよね?難しいことを機械にやらせちゃおうというのだからすごいです!

DIVINEでの音を除去する方法としては

- 観測信号から音(ノイズ)だけのとこをまずカット(時間軸上の分割)

- 音声部分から音(ノイズ)の影響を除去(周波数上の分割)

…難しいですね。ノイズを時間的に追従して、どこがノイズかを予測計算して抽出・除去するので、精度がとってもいいそうです。軽量化できており、組み込み機器への搭載も問題ないとのこと。そのうちAndroid端末への搭載もアリ?ですね!

今後の課題としては、雑音の定義はひとそれぞれなところ。オカーサンのうるさい小言も聞きようによってはありがたい忠告ですし、単なる雑音だったりもします。と考えると、音の時空間位置を特定し、聞きたくない音を取り除く技術へが必要になります。それには、どんな内容の文を誰がしゃべっているのかを区別 する仕組みが必要です。そのためにNTTさんでは日夜研究開発に取り組まれているそうです!がんばって!

声を言葉として理解する仕組み…WFSTを使った音声認識エンジン

次に、DIVINEで取り出した人の声を言葉として理解して聞く仕組みが必要です。声を言葉にして理解するためには、以下のような3つの処理を順番に行います。

- 声を一つ一つの音節として理解する (例)「し」「ろ」「い」「は」「な」「が」「さ」「い」「た」

- 一つ一つの音節を単語にする (例)「しろい」「はな」「が」「さいた」

- 単語を組み合わせて文脈にあった文をつくる (例)「白い花」○「白い鼻」× 「が」○ 「咲いた」○「最多」×

音声認識エンジンは、この3つの処理のそれぞれにモデルと呼ばれる辞書のようなものを準備して、入力された音と合致するものを探索します。そして最も最適な言葉の並びが何になるのかを判断します。

きちんと意図したとおりの文を機械が認識するためには、多くのパターンを準備して、その中から正確に意図通りのパターンを探す処理が必要となってしまいます。例えば10個の単語でできた文章の場合、それぞれ同音の語彙がNパターンあるとした場合の文章の組み合わせは、Nの10乗通りもあるからです。N=2 の場合は1024通りですが、N=10の場合は10,000,000,000通り!いくら最近の携帯はお利口さんとはいえ、あのような小さなサイズの機械ではこのような多くの処理はできそうにもありません!オーバーヒートして煙がでちゃいそうです!

そこでNTTでは新しくWFSTと呼ばれる独自の技術を研究開発されました。これは、3つの処理を1つ1つ実行するのではなくて、合成して一気に処理させよう!といったものです。

きちんと意図したとおりの文を機械が認識するためには、多くのパターンを準備して、その中から正確に意図通りのパターンを探す処理が必要となってしまいます。例えば10個の単語でできた文章の場合、それぞれ同音の語彙がNパターンあるとした場合の文章の組み合わせは、Nの10乗通りもあるからです。N=2 の場合は1024通りですが、N=10の場合は10,000,000,000通り!いくら最近の携帯はお利口さんとはいえ、あのような小さなサイズの機械ではこのような多くの処理はできそうにもありません!オーバーヒートして煙がでちゃいそうです!

そこでNTTでは新しくWFSTと呼ばれる独自の技術を研究開発されました。これは、3つの処理を1つ1つ実行するのではなくて、合成して一気に処理させよう!といったものです。

音声認識のようなTransducerにはよく有限オートマトン(FSM) が使用されますが、NTTで開発されたWFSTも有限オートマトンの一種です。重みだけでなく、入力値/出力値をもつことが特徴です。音声認識の3つモデルはそれぞれ異なった仕組みで探索しますが、WFSTではこれらの仕組みを包括しますので、合成した場合のアルゴリズムとしてWFSTはとっても適しているといえ ます。

この合成によって、今まで音声の特徴量→音素→単語→文という処理だったのが、特徴量→文とダイレクトに短時間で検索することができます。WFSTを使ったおかげで、処理がすっごく早くてすっごく認識精度のいい音声認識エンジンを処理することできました。

この結果、NTTでは世界で初めて短時間で1000万語もの音声認識処理が可能なエンジンを開発しました。広辞苑ですら24万語ですから、それだけすごいかわかりますよね?現在この技術は、アメリカのMITでのオンライン講義などに応用されているそうです。英語の講義に字幕をつけて、まるでカラオケでの歌詞のように映像と同期する字幕を自動で作成する仕組みです。世界で日本のNTTさんの技術が活用されています。すごいですね!

今後の課題としては、認識率の向上をあげられてました。一般的に音声認識率についてよく質問されるのだそうですが、条件が違えば認識率が異なるので一概には回答できないもののようです。例えば、一人の人の声をヘッドセットで拾う場合と、2、3人でおしゃべりする音声をマイクで拾う場合とは認識率が全く違います。もちろん前者の方が簡単なしくみで認識できるようで、現在の技術では前者は90%程度、後者は50〜55%程度の認識率だそうです。これから複数の人の会話でもちゃんと認識出来るようなエンジンの研究をすすめられているとのこと。とても未来を感じる研究ですね!いつかくる素晴らしい未来のために、わたしたちも応援したいです!

まるで大学の授業のような理論中心のセッションでした。次のセッションではもう少し実践編というか、日常的な音声認識のサービス・アプリについての内容になっております。乞うご期待!

この結果、NTTでは世界で初めて短時間で1000万語もの音声認識処理が可能なエンジンを開発しました。広辞苑ですら24万語ですから、それだけすごいかわかりますよね?現在この技術は、アメリカのMITでのオンライン講義などに応用されているそうです。英語の講義に字幕をつけて、まるでカラオケでの歌詞のように映像と同期する字幕を自動で作成する仕組みです。世界で日本のNTTさんの技術が活用されています。すごいですね!

今後の課題としては、認識率の向上をあげられてました。一般的に音声認識率についてよく質問されるのだそうですが、条件が違えば認識率が異なるので一概には回答できないもののようです。例えば、一人の人の声をヘッドセットで拾う場合と、2、3人でおしゃべりする音声をマイクで拾う場合とは認識率が全く違います。もちろん前者の方が簡単なしくみで認識できるようで、現在の技術では前者は90%程度、後者は50〜55%程度の認識率だそうです。これから複数の人の会話でもちゃんと認識出来るようなエンジンの研究をすすめられているとのこと。とても未来を感じる研究ですね!いつかくる素晴らしい未来のために、わたしたちも応援したいです!

まるで大学の授業のような理論中心のセッションでした。次のセッションではもう少し実践編というか、日常的な音声認識のサービス・アプリについての内容になっております。乞うご期待!

登録:

投稿 (Atom)