次のセッションでは、NTTサイバースペース研究所の高橋 敏さん。先ほどの中村さんの基礎技術を応用していろいろなアプリ・サービスを開発されているそうです。このセッションでは音声認識エンジンのサービスへの応用例と、音声認識ならではのサービスづくりのコツについてご披露いただきました。なんて太っ腹!高橋さん曰く、少しでも良いサービス、アプリ開発のヒントになればとのこと。聞いたかAndroid開発者の諸君!立ち上がれ!

まずはNTTの音声認識エンジンVoiceRexのご紹介です。分散型音声認識を行っています。これは端的に言うと、サーバクライアントシステムです。音声認識の処理をクライアント側とサーバ側に分けて実施します。android携帯のような、クライアント側で特徴量算出・符号化・ 圧縮までを行い、そのデータをサーバ側へ送信して音声認識処理を行います。もちろん、複数人の音声認識に対応しています。そして、VoiceRexを使ったサービスは、次の3パターンに大別されるそう。

- 音声インタフェースとしての利用(音声コマンド)

- ディクテーションとしての利用(口述筆記)

- 音声マイニングとしての利用

それぞれどういったサービスで使われているか、実際デモしていただき、具体的にわかりやすくご紹介いただきました。

音声インタフェースとしての利用(音声コマンド)

キーボードやマウスの代わりに人の声で機械を操作しよう!といったものです。今回は音声カーナビとTV番組表検索エージェントのデモを披露していただけました。人が何回も言い間違えるようなことがあっても、間違いに的確に対応して本来の正しい答えを返しており、まるで機械の中に人がいるようです!すばらしい!認識自体は文脈で判断するため、方言にイントネーションの違いがあっても大丈夫。例えば、「箸」と「橋」の違いなどは全然問題ないそうです。

ただたまにとんでもない間違いをすることがあるらしく、音声カーナビなどありえないルートを示すことも。そのような時は、開発者のサガというか、正しいルートがでるまで意地でも何回も機械と会話をしてしまうそうです。なんだかほほえましいながら地道な努力!

ディクテーションとしての利用(口述筆記)

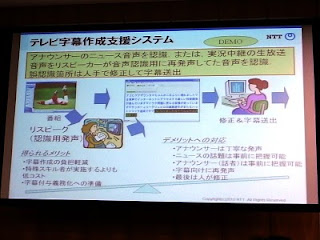

会話の内容を、話すそばから自動的に記録としてテキストで残すようなサービスです。たしかに、話した内容をあとから思い出して正確にテキストにおこす作業は大変ですよね。今回はTV字幕作成支援システムと議会録作成システムをご紹介いただきました。

TV字幕作成システムでは、ニュースでアナウンサーが話すような情報をテキストにおこします。しかし話し言葉は書き言葉に比べて、無駄な情報がどうしても多くなります。ニュース番組だとある程度情報が整理されたうえで話をきくことができますが、これがバラエティだととても大変とのこと。実験的に、おしゃべりな司会者で有名なみのもんたさんの番組で試したところ、とてつもなく大変なことになったそうです。でもご安心。このような場合、リスピークといった字幕専用のアナウンスをすることで対処しているそうです。また細かい間違いはどうしても残ってしまうのでこれは手作業で直すそうです。でも一から入力するよりも作業の負担が減るので有意義なシステムですね!現在実用化に向けて開発が進められているそうです。

もうひとつ、ご紹介いただいた音声議会録作成システムは、国会などの議会での記録とるようなシステムです。これも、TV字幕作成と同様の課題をかかえており、議会などには適していますが、会社の会議などの場合には適さないようです。何がどう異なるのでしょうか?その違いをわかりやすく提示していただきました。

| 議会(国会など) | 会議(会社でのミーティングなど) |

|

|

やはり、なんとなく話すような話し言葉は情報が整理されていないので、要点をいかにまとめるか?というところがこのサービスの大きな課題になるようです。

音声マイニングとしての利用

大量の音声情報から必要なものだけを抽出するようなサービスです。これは最近はやりのサービスだそうで、主にコールセンターで利用されています。コールセンターにかけた電話で苦情や要望などを話すと、自動的に内容を解釈し、マーケティングをしたり、苦情の傾向・分析を行うそうです。またコールセンターのオペレーターがちゃんと丁寧に応対しているかってことも分析するそうです。これはオペレータの方はサボれませんね。しかし、消費者の声がダイレクトに素早く企業に届くことになりますので、我々にとってはありがたい技術です!

音声認識の技術をサービス・アプリにいかすには?

音声認識がサービスとして使われる場合、いっぱい良いところがあります。まずは、人に優しいインタフェースであること。会話ができる人ならば誰でも簡単に使えちゃうところです。例えばキーボードの操作に慣れていない高齢者の方、または手に怪我をされていたり大きな荷物を持っていたりなどで操作ができない人でも簡単に話すだけで操作できちゃいます。また、最小限マイクとスピーカーがあれば実現できるので、場所もとらないでサービスを受けることができます。

でもでも、まだ発展途上の技術なので、音声認識ならではの欠点もまだあります。

- 機械も聞き間違えをする

- しかも人間の場合だとありえないようなとんでもない間違い

- 同じ間違いを何度も繰り返す

- 入力音声には制約がある

- 発話する環境次第で、処理の精度が変わる

- 要点をまとめてしゃべるようにしないと正確に処理できない

- どういう言葉をどういうふうにしゃべったらいいのか利用者にわかりづらい

- 音声認識辞書にない新しい単語は認識できない

- そもそも音声認識が適用しやすいサービスで使用すること

- 間違って入力しても簡単に訂正できるような仕組みを作ること

- なにをしゃべったらよいかをわかりやすく利用者に示すこと

- サービスの用途に合わせて辞書を充実させること

そして最後ですが、最大の課題があります。

端末に向かってしゃべる文化をいかに当たり前にするか?

人が機械に向かってしゃべるのは、心理的に抵抗がありませんか?最近は携帯電話に向かって話すことは当たり前になりましたが、これは携帯電話を持っているから平気なのです。例えば電話を持たずにヘッドセットにしゃべるのはどうでしょう?結構キツイですよね。またヘッドセットでしゃべっている人と出会うだけでもギョッとする。そういう人はまだまだ多いです。しかし、こういった抵抗感を意識せずに使ってもらえるようなサービスを提供すること。これが音声認識の一番の課題であり、そして音声認識がどんどん進化するための絶対条件になります。そして我々のようなAndroidアプリ開発者にも、アプリやサービスの開発によって、そのような文化へと進化させることに期待しています、との締めの言葉でこのセッションは終了いたしました。

壮大すぎる!結構なムチャぶりですね!でももし既存の文化がくつがえるようなサービスが実現できたなら…。それは確実に世の中が変わる一つのきっかけになるでしょう。あなたならどうしますか?

さてさて、次のセッションでは、スペインのバルセロナで開催された携帯電話の世界的イベント、MWC2010の模様をレポートします!

0 件のコメント:

コメントを投稿